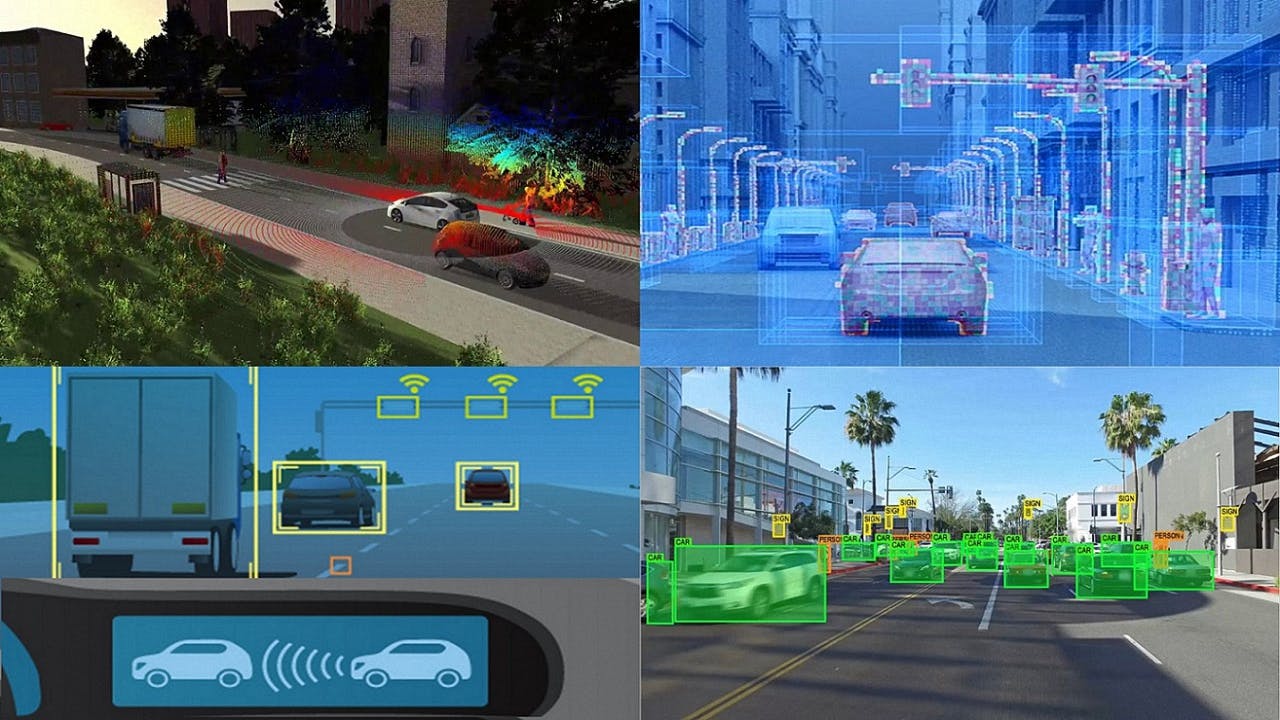

Les véhicules autonomes utilisent de nombreux capteurs pour analyser les scénarios de conduite. La fusion des données de ces capteurs exploite le machine learning et intègre les données des capteurs multimodaux pour une compréhension précise et continue de l’environnement de conduite. Cette interprétation des scénarios est ensuite utilisée pour apprendre un comportement de conduite adapté et des pratiques de circulation réalistes.

Dans ce webinaire à la demande, nos experts vous expliquent de quelle manière la fusion des données des capteurs et le deep learning (apprentissage approfondi) permettent aux véhicules autonomes de parvenir à une compréhension précise des scènes de conduite et de la navigation à suivre.

Quelques exemples :

- Détection et suivi multicapteur et multi-objet, localisation et cartographie

- Visualisation de scénarios permettant de renforcer les pratiques de conduite du véhicule autonome à l’aide des techniques de deep learning (par imitation ou/et par renforcement)

- Génération de scénarios virtuels et validation à base de simulation

Intervenants :

À propos de l'intervenant

François Gerard

Directeur du développement des services d’ingénierie